Por que o HDMI-DVI oferece uma imagem mais nítida do que o VGA?

Com todo o excelente hardware disponível nos dias de hoje, parece que devemos estar desfrutando de uma ótima qualidade de visualização, não importa o que aconteça, mas e se esse não for o caso? O post de perguntas e respostas do SuperUser de hoje procura esclarecer as coisas para um leitor confuso.

A sessão de perguntas e respostas de hoje nos é oferecida por cortesia do SuperUser - uma subdivisão do Stack Exchange, um agrupamento de sites de perguntas e respostas conduzido pela comunidade..

Foto cedida por lge (Flickr).

A questão

O alkamid do leitor SuperUser quer saber por que existe uma diferença notável na qualidade entre HDMI-DVI e VGA:

Eu tenho um monitor Dell U2312HM conectado a um laptop Dell Latitude E7440. Quando conecto via laptop -> cabo HDMI -> adaptador HDMI-DVI -> monitor (o monitor não tem um soquete HDMI), a imagem é muito mais nítida do que se eu conectasse via laptop -> adaptador miniDisplayPort-VGA -> VGA cabo -> monitor.

A diferença é difícil de capturar com uma câmera, mas veja minha tentativa abaixo. Tentei brincar com as configurações de brilho, contraste e nitidez, mas não consigo obter a mesma qualidade de imagem. A resolução é 1920 * 1080 com o Ubuntu 14.04 como meu sistema operacional.

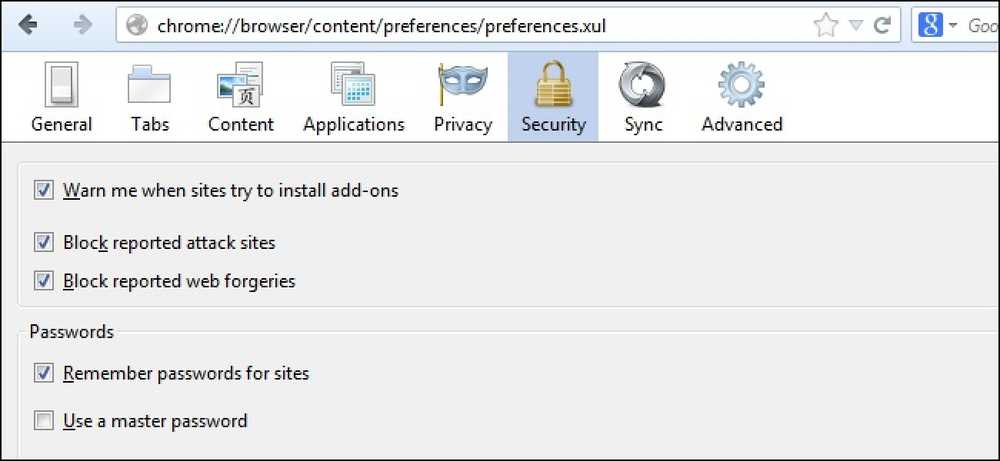

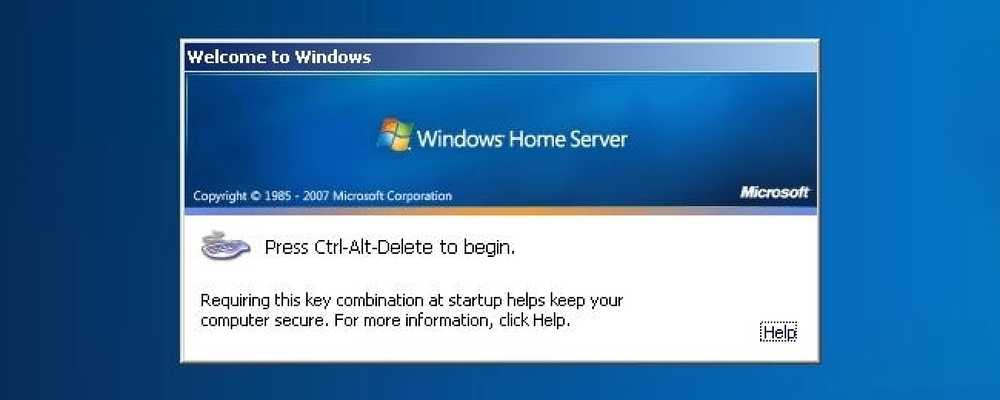

VGA:

HDMI:

Por que a qualidade é diferente? É intrínseco a esses padrões? Eu poderia ter um cabo VGA defeituoso ou adaptador mDP-VGA?

Por que há uma diferença de qualidade entre os dois?

A resposta

Os colaboradores do SuperUser, Mate Juhasz, youngwt e Jarrod Christman, têm a resposta para nós. Primeiro, Mate Juhasz:

VGA é o único sinal analógico entre os mencionados acima, então já é uma explicação para a diferença. Usando o adaptador pode piorar ainda mais a qualidade.

Algumas outras leituras: HDMI vs. DisplayPort vs. DVI vs. VGA

Seguido pela resposta do jovem:

Assumindo que o brilho, o contraste e a nitidez são os mesmos em ambos os casos, pode haver duas outras razões pelas quais o texto é mais nítido com HDMI-DVI.

O primeiro já foi dito, o VGA é analógico, então ele precisará passar por uma conversão analógica para digital dentro do monitor. Isso teoricamente irá degradar a qualidade da imagem.

Segundo, supondo que você esteja usando o Windows, existe uma técnica chamada ClearType (desenvolvida pela Microsoft) que melhora a aparência do texto manipulando os subpixels de um monitor LCD. VGA foi desenvolvido com monitores CRT em mente e a noção de um sub pixel não é a mesma. Devido à necessidade de o ClearType usar uma tela LCD e o fato de que o padrão VGA não informa ao host as especificações da tela, o ClearType seria desativado com uma conexão VGA.

Eu me lembro de ouvir sobre o ClearType de um de seus criadores em um podcast para This (). Developers (). Life () IIRC, mas este artigo da Wikipedia também suporta minha teoria. Também HDMI é compatível com DVI e DVI suporta Electronic Display Identification (EDID).

Com a nossa resposta final de Jarrod Christman:

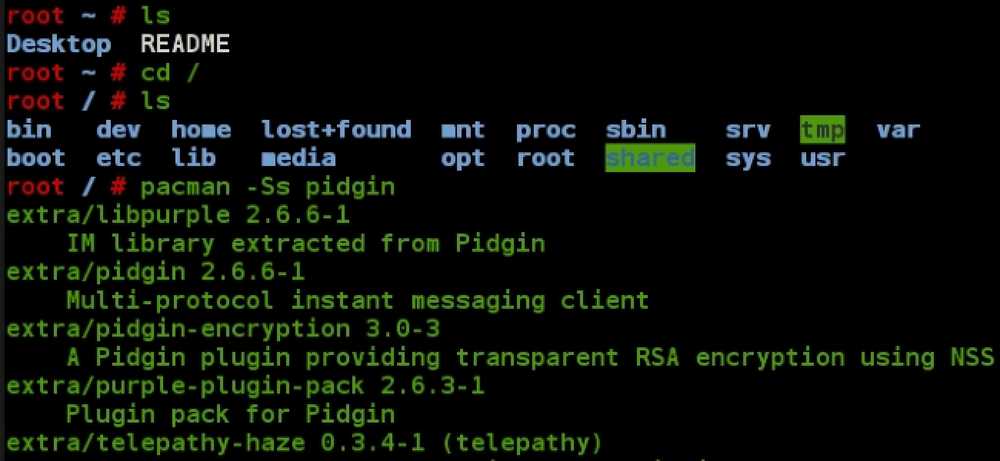

Os outros fazem alguns pontos positivos, mas a principal razão é um desfasamento óbvio de relógio e fase. A VGA é analógica e está sujeita a interferências e incompatibilidade dos lados de envio e recepção analógicos. Normalmente, um usaria um padrão como este:

Relógio e fase

Em seguida, ajuste o relógio e a fase do monitor para obter a melhor correspondência e a imagem mais nítida. No entanto, uma vez que é analógico, esses ajustes podem mudar ao longo do tempo e, portanto, você deve idealmente usar apenas um sinal digital.

Tem algo a acrescentar à explicação? Som desligado nos comentários. Quer ler mais respostas de outros usuários do Stack Exchange com experiência em tecnologia? Confira o tópico de discussão completo aqui.